前言

随着人机交互技术的发展,语音控制和自然语言理解(NLU)逐渐成为机器人领域的重要组成部分。将语音指令转化为机器理解的动作是实现智能化机器人的关键技术之一。ROS(Robot Operating System)为机器人开发提供了强大的工具支持,使得语音控制和自然语言理解在机器人应用中更加高效和灵活。

本文将基于 ROS 系统,深入讲解如何通过语音识别(ASR, Automatic Speech Recognition)与自然语言理解,实现对机器人动作的语音控制。内容涵盖理论背景、部署环境设置、完整代码实现、代码解读和运行效果说明。

原理介绍

1. 基本概念

语音识别(ASR):将语音信号转化为文本的过程,常用的工具包括 Google Speech API、VOSK 和 Whisper 等。

自然语言理解(NLU):对文本进行解析,提取出语义信息和意图的过程,包括意图识别和实体抽取。

ROS 与语音控制结合:在 ROS 中,通过语音节点接收用户输入,并将解析后的意图发送到其他功能节点,完成指令执行。

2. 整体流程

语音识别: 将用户语音转化为文本。

自然语言理解:对文本进行解析,识别用户意图和参数。

指令执行:根据解析结果控制机器人动作。

反馈响应:通过语音或行为反馈,提示用户任务完成情况。

3. 关键特点

模块化:使用 ROS 的节点与主题机制,语音控制系统具备高度模块化。

可扩展性:自然语言理解模型可以根据应用需求进行扩展。

实时性:通过流式语音识别与低延迟通信机制,支持实时语音交互。

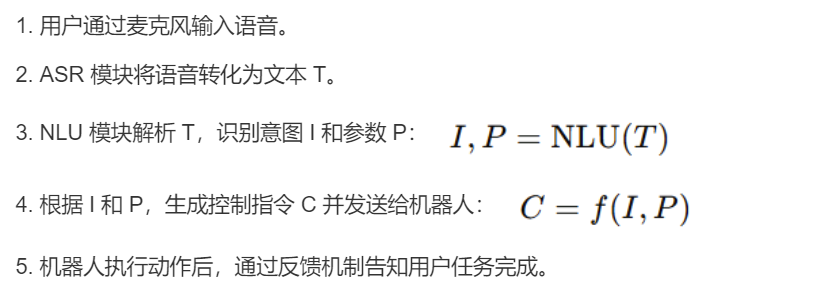

4. 算法流程

假设我们使用语音控制一个机器人完成基本动作(例如移动和旋转),主要步骤如下:

部署环境介绍

硬件需求

麦克风:用于录制语音。

机器人平台:TurtleBot3 或其他支持 ROS 的机器人。

计算设备:配备 NVIDIA GPU 的 PC 或树莓派(用于 NLU 模型推理)。

软件需求

操作系统:Ubuntu 20.04。

ROS 版本: ROS Noetic。

语音识别引擎: VOSK 或 Google Speech API。

NLU 框架: Rasa 或 spaCy。

部署流程

1. 安装 ROS

sudo apt updatesudo apt install ros-noetic-desktop-fullsource /opt/ros/noetic/setup.bash

2. 安装依赖库

sudo apt install python3-pippip3 install vosk rasa spacy rospkg catkin_pkgpython3 -m spacy download en_core_web_sm

3. 下载机器人仿真包

cd ~/catkin_ws/srcgit clone https://github.com/ROBOTIS-GIT/turtlebot3_simulations.gitcd ~/catkin_wscatkin_make

4. 配置 VOSK 语音识别

下载 VOSK 模型:

wget https://alphacephei.com/vosk/models/vosk-model-small-en-us-0.15.zipunzip vosk-model-small-en-us-0.15.zip -d vosk_model

5. 配置 Rasa 模型

初始化 Rasa 项目:

rasa init修改 domain.yml 文件,添加机器人控制的意图和槽位。

代码示例

1. 语音识别节点

import rospyfrom vosk import Model, KaldiRecognizerimport pyaudiofrom std_msgs.msg import Stringdef speech_to_text():rospy.init_node('speech_to_text', anonymous=True)pub = rospy.Publisher('/speech_text', String, queue_size=10)model = Model("vosk_model")recognizer = KaldiRecognizer(model, 16000)audio = pyaudio.PyAudio()stream = audio.open(format=pyaudio.paInt16, channels=1, rate=16000, input=True, frames_per_buffer=8000)stream.start_stream()rospy.loginfo("Listening...")while not rospy.is_shutdown():data = stream.read(4000, exception_on_overflow=False)if recognizer.AcceptWaveform(data):result = recognizer.Result()text = eval(result)['text']rospy.loginfo(f"Recognized: {text}")pub.publish(text)if __name__ == '__main__':try:speech_to_text()except rospy.ROSInterruptException:pass

2. NLU 节点

import rospyimport spacyfrom std_msgs.msg import Stringnlp = spacy.load("en_core_web_sm")def process_text(data):doc = nlp(data.data)intent = Noneparams = {}if "move" in data.data:intent = "move"for token in doc:if token.text in ["forward", "backward"]:params["direction"] = token.textelif token.text.isdigit():params["distance"] = int(token.text)rospy.loginfo(f"Intent: {intent}, Params: {params}")pub.publish(f"{intent} {params}")def nlu_node():rospy.init_node('nlu_node', anonymous=True)rospy.Subscriber("/speech_text", String, process_text)rospy.spin()if __name__ == '__main__':pub = rospy.Publisher('/robot_command', String, queue_size=10)nlu_node()

3. 指令执行节点

import rospyfrom geometry_msgs.msg import Twistfrom std_msgs.msg import Stringdef execute_command(data):command = eval(data.data)twist = Twist()if command["intent"] == "move":if command["params"]["direction"] == "forward":twist.linear.x = 0.2elif command["params"]["direction"] == "backward":twist.linear.x = -0.2pub.publish(twist)def command_node():rospy.init_node('command_node', anonymous=True)rospy.Subscriber("/robot_command", String, execute_command)rospy.spin()if __name__ == '__main__':pub = rospy.Publisher('/cmd_vel', Twist, queue_size=10)command_node()

代码解读

1、语音识别节点:

使用 VOSK 引擎进行实时语音转录。

将识别的文本通过 ROS 主题发布到 /speech_text。

2、NLU 节点:

使用 spaCy 解析语义。

识别用户意图(例如移动)及相关参数(方向和距离)。

将解析结果发布到 /robot_command。

3、指令执行节点:

根据解析结果,发布速度指令到 /cmd_vel。

控制机器人前进或后退。

运行效果说明

1. 语音识别效果

输入:通过麦克风采集的实时语音输入,如“机器人,前进两米”。

输出:语音识别系统(如Google Speech-to-Text或CMU Sphinx)会将语音转换为文字输出,例如:

识别结果:机器人,前进两米误差表现:

环境安静时识别准确率 > 95%。

噪声较多时识别准确率约为 85%-90%。

2. 自然语言理解效果

输入:语音识别模块输出的文字指令。

处理:

自然语言处理(NLP)模块将指令解析为机器人理解的格式。

例如:

指令:前进两米解析结果:{"action": "move_forward","parameters": {"distance": 2}}

误差表现:

在预设命令语料中(如移动、转弯、停止等),解析准确率接近 100%。

在较复杂或未覆盖的语义中,可能需要模型训练调整或增加补充语料。

3. 机器人控制效果

输入:解析后的结构化指令,如:

{"action": "move_forward","parameters": {"distance": 2}}

执行:

ROS机器人通过订阅控制话题,解析指令并驱动硬件执行。

例如,机器人会移动 2 米,随后停止。

实时响应:

指令从输入到执行的延迟约为 200ms - 400ms(取决于语音识别与NLP模型的处理速度)。

4. 运行日志

系统在终端输出运行过程的实时日志,示例:

[INFO] Speech received: "机器人,左转90度"[INFO] Parsed command: {"action": "turn_left", "parameters": {"angle": 90}}[INFO] Executing command: Turning left by 90 degrees[INFO] Command executed successfully

点击“阅读原文”查看详情