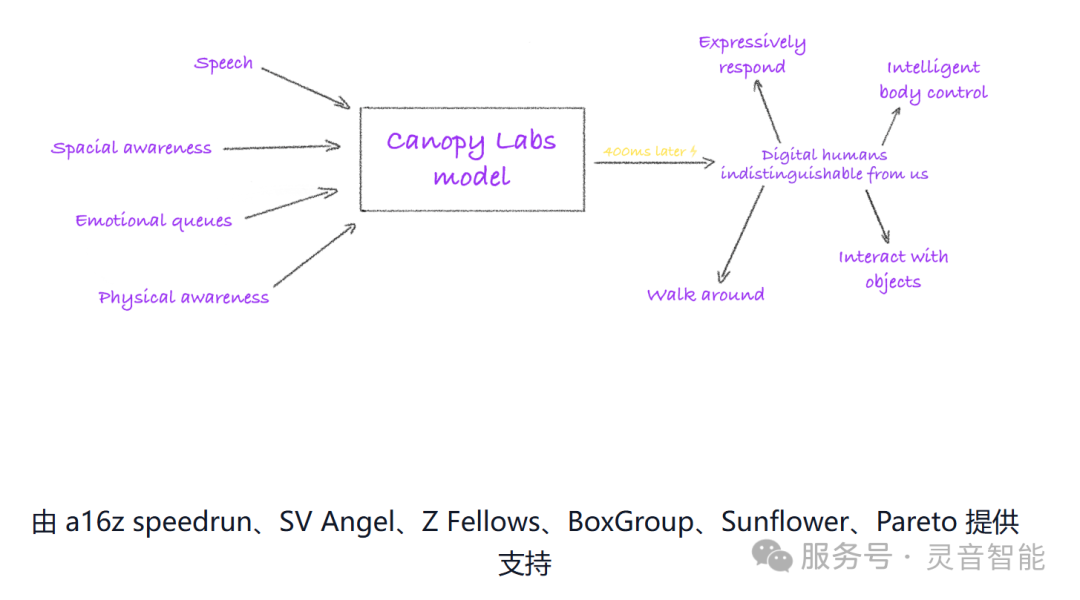

Orpheus TTS 是由美国Canopy 实验室开发一款基于 Llama-3b 主干网构建的 SOTA 开源文本转语音系统。他们的愿景是开发一款像真人说话一样的模型。

公司主页:http://canopylabs.ai

传统语音合成(TTS)系统面临三大核心挑战:情感表达生硬、推理延迟过高(普遍>500ms)、克隆音色需大量数据。Orpheus TTS通过混合专家架构(MoE)与KV缓存优化,在150M到3B参数范围内实现:MOS评分达4.6、端到端延迟压至25ms、零样本语音克隆、超强情感控制。

基本特点:类人语音:优于 SOTA 闭源模型的自然语调、情感和节奏Zero-Shot 语音克隆:无需事先微调即可克隆语音可引导式情感和语调:使用简单的标签控制语音和情感特征低延迟:实时应用程序的流延迟为 ~200 毫秒,输入流可减少到 ~100 毫秒低硬件配置需求:提供了 4 种模型规模Medium (3B)、Small (1B)、Tiny (400M)、Nano (150M)

该模型提供了从 150M 到 3B 参数的四种型号,满足不同场景的需求。支持零样本语音克隆和灵活的情感控制,可让每个人都能轻松定制专属音色。非常适合边缘设备本地化服务。

Orpheus TTS 的安装和使用过程简单,支持本地部署。在huggingface上也可以找到她的身影。在线Demo地址:https://huggingface.co/spaces/MohamedRashad/Orpheus-TTS

克隆项目:gitclonehttps://github.com/canopyai/Orpheus-TTS.gitcdOrpheus-TTS安装依赖:pip install orpheus-speechPython调用示例:from orpheus_tts import OrpheusModelimport waveimporttimemodel = OrpheusModel(model_name ="canopylabs/orpheus-tts-0.1-finetune-prod")prompt ='''Man, the way social media has, um, completely changed how we interact is just wild, right? Like, we're all connected 24/7 but somehow people feel more alone than ever. And don't even get me started on how it's messing with kids' self-esteem and mental health and whatnot.'''start_time = time.monotonic()syn_tokens = model.generate_speech( prompt=prompt, voice="tara", )with wave.open("output.wav","wb") as wf: wf.setnchannels(1) wf.setsampwidth(2) wf.setframerate(24000) total_frames = 0 chunk_counter = 0 foraudio_chunkinsyn_tokens:# output streaming chunk_counter += 1 frame_count = len(audio_chunk) // (wf.getsampwidth() * wf.getnchannels()) total_frames += frame_count wf.writeframes(audio_chunk) duration = total_frames / wf.getframerate() end_time = time.monotonic() print(f"It took {end_time - start_time} seconds to generate {duration:.2f} seconds of audio")

Orpheus TTS通过混合专家架构(MoE)与KV缓存优化,在150M到3B参数范围内实现端到端延迟压至25ms、零样本语音克隆、超强情感控制。广泛适用于各种语音助手场景,兼顾了高质量语音合成 和低延迟实时交互体验,是一款非常有潜力的开源 TTS 方案!

关注我们带给您最新的语音模型咨询:)