实时语音交互作为人机协作的基本接口,具有巨大的潜力。然而,目前的开源模型面临着语音数据采集成本高、动态控制能力弱、智能有限等局限性。为了应对这些挑战,本文介绍了Step-Audio,这是第一个生产就绪的开源解决方案。主要贡献包括:1)130B参数的统一语音-文本多模态模型,实现统一理解和统一生成,Step-Audio-Chat版本开源;2) 生成式语音数据引擎,建立可负担的语音克隆框架,并通过蒸馏生成开源轻量级 Step-Audio-TTS-3B模型;3)指令驱动的精细控制系统,实现方言、情绪、唱腔、RAP的动态调节;4) 增强的认知架构,增强了工具调用和角色扮演能力,可以有效地管理复杂的任务。基于我们新的StepEvalAudio-360 评估基准,Step-Audio 在人类评估方面实现了最先进的性能,特别是在指令遵循方面。在像LLaMA Question这样的开源基准测试中,平均性能提高了9.3%,这表明我们致力于推进开源多模态语言技术的发展。我们的代码和模型可在https://github.com/stepfun-ai/Step-Audio上获得。

Introduction

人工智能向通用系统的发展已经将实时语音交互定位为人机协作的关键接口。虽然最近的多模态大型语言模型(llm)加速了这一领域的进展,但尽管gpt - 4o 和豆包 等专有系统取得了突破,开源社区仍面临着持续的挑战。现有的开源模型,如Qwen2-Audio 、Llama 3 和wavLLM 面临三个基本限制:理解和生成过程的分离,阻碍了端到端系统集成;依赖于费力的人工语音数据采集方法,限制了高效的语音复制;在调节韵律特征、区域方言和工具利用能力方面的精度不足。这些限制突出了对可部署框架的迫切需求,这些框架将 streamlined 架构与情感计算(准确的情绪感知和调整)和上下文认知(情景推理和反应制定)的双重能力协调起来。

当前的开源语音系统面临着多种架构上的挑战。传统框架采用级联方法,结合自动语音识别(ASR)、LLM处理和文本到语音(TTS)。该框架通过模态转换引入了错误传播,同时增加了系统复杂性。纯端到端方法虽然在概念上很优雅,但往往会牺牲开放域对话质量的性能。模块化设计和完全集成系统之间的紧张关系仍然没有得到解决。此外,传统的文本到语音管道依赖于人工整理的数据集,特别是对于多语言和多方言场景,这一过程需要大量的人工注释工作。现有的解决方案还缺乏复杂的动态语音适应控制机制,例如实时调整语速、情绪韵律或音乐呈现(例如,唱歌和RAP声乐)。至关重要的是,缺乏工具调用功能和上下文感知会妨碍处理复杂的查询,比如“检索实时天气数据并以广东话报告”,这就需要手动集成API。

该报告介绍了Step-Audio,这是第一个用于智能语音交互的生产就绪开源框架,它通过四个关键创新来协调理解和生成。

-

•130B-Parameter Multi-modal Model: 集成理解和生成能力的单一统一模型,可进行语音识别、语义理解、对话、语音克隆、音频编辑和语音合成。我们已经将130B Step-Audio-Chat变体开源。 -

•Generative Data Engine:通过我们的 130B 参数多模态模型生成高质量音频,消除了传统TTS对手动数据收集的依赖。利用这些数据来训练和公开发布资源高效的 Step-Audio-TTS-3B模型,具有增强的可控语音合成指令跟随能力。 -

•Granular Voice Control: 通过指令式控制设计实现精准调节,支持多种情绪(愤怒、喜悦、悲伤)、方言(广东话、四川话等)、发声风格(RAP/Singing、无伴奏哼唱),满足多样化的语音生成需求。 -

•Enhanced Intelligence: 通过ToolCall机制集成和角色扮演增强,提高代理在复杂任务中的性能。

在开源基准测试中,Step-Audio展示了出色的性能。它在开放领域的问答和复杂的指令任务(包括LLaMA question、TrivialQA和ComplexBench)上取得了SoTA的成绩,与最好的开源指标相比,平均提高了9.3分,验证了它在广义深度语义理解能力方面的优势。此外,为了解决目前缺乏全面的端到端语音对话评估系统的问题,我们引入了包含9个维度的多维StepEval-Audio-360评估框架,包括逻辑推理、创造能力、语言能力和理解控制等关键能力。如图1所示,Step-Audio与开源模型(如GLM-4-Voice和Qwen2-Audio)进行主观比较,在所有维度上都取得了SoTA结果,在响应质量、响应相关性和事实准确性方面分别提高了19.2%、23.7%和43.2%。特别是在情感理解、语速控制、RAP声乐和角色扮演等生成控制维度上,与开源SoTA模型相比,IF (Instruction Following)和MOS (Mean Opinion Score)指标分别提高了29.8%和27.1%,突出了其在复杂语音交互场景中的领先优势。

Related Work

端到端语音系统的最新进展显著改善了人机音频交互。早期的方法依赖于级联的 ASR-LLM-TTS管道,其中语音识别、语言建模和语音合成的不同模块依次连接。然而,这些系统受到延迟积累、错误传播和脱节优化的困扰。后来的方法试图通过可训练的适配器将语音编码器直接连接到llm,从而增强集成,尽管它们仍然需要单独的TTS模块用于音频输出。

完全端到端系统的出现标志着范式的转变。Llama-Omni等架构将非自回归(NAR) TTS模块与语言模型集成在一起,使用 connectionist temporal classification(CTC)损失。Freeze-Omni使用自回归和NAR语音解码器的组合。这些系统表现出改善的延迟,但在处理情感细微差别和自然会话流方面表现出局限性。MinMo通过CosyVoice2解码器引入了自回归语音令牌预测,而交错建模方法在序列级上交替生成文本和语音令牌。

像Moshi和MiniOmni这样的并行解码架构通过同时生成文本和多个语音码本令牌代表了一个重大飞跃。这些系统通过压缩语音令牌序列实现较低的延迟,但在扩展语音令牌带宽时面临保持语言功能的挑战。当前的系统通常专注于特定方面:GLM-4-Voice优先考虑延迟减少,而Moshi强调语音质量,但没有一个全面解决情感感知、会话自然性和实时知识集成。

最近的方法进展已经系统地研究了情绪感知交互范式,尽管它们与多模态框架的整合仍处于初期阶段。虽然一些系统结合了基本的情感分析,但它们缺乏双向情感共鸣——既不能检测用户语音中的副语言线索,也不能产生上下文适当的情感响应。由于LLM倾向于冗长、文本优化的输出,不适合口语对话,因此自然度差距持续存在。最近的工作引入了特定于任务的优化:LUCY采用了Mini-Omni的架构框架,并对情感控制和函数调用的会话数据集进行了专门的微调。

Architecture

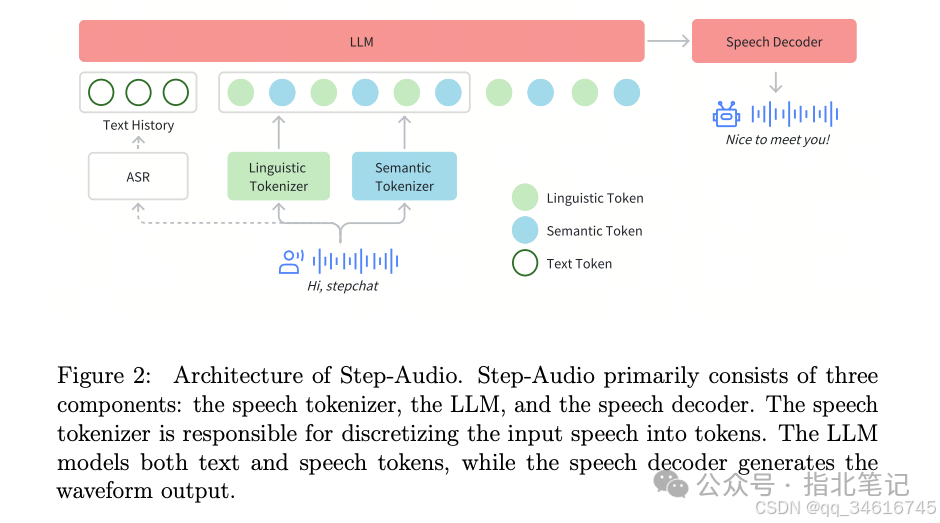

传统的语音对话系统通常采用由ASR、LLM和TTS模块组成的级联架构。然而,我们提出的模型在预训练阶段经历了全面的多模态训练,文本和音频对齐,已经具备了端到端的语音对话能力。尽管对替代设计进行了广泛的探索,但我们最终采用了AQTA(audio input, text output) + TTS框架进行实时语音对话,如图2所示,出于以下考虑:

-

•Scarcity of high-quality pure-voice dialogue data:纯语音对话数据的可用性有限,再加上场景的约束,限制了端到端语音对话模型的训练效率。 -

•Controllability and customization of output speech: 通过加入TTS模块,我们可以灵活控制音色(timbre)、音高(pitch)等语音参数,以满足用户的个性化需求,同时不断增强模型的表达能力。

我们的目标是将Step-Audio作为一个实时多模态模型,通过四个关键组件无缝集成语音理解和合成:(1) 采用并行linguistic(16.7Hz, 1024码本)和semantic(25Hz, 4096码本)标记器的 dual-codebook tokenization 框架,并采用 2:3 时间交错;(2) 基于Step-1的130B 参数LLM,通过音频情境化的持续预训练和后训练的约束增强;(3) 结合 flow matching 和神经声码器的混合语音合成器,针对实时波形生成进行优化。此外,采用语音活动检测(Voice Activity Detection, VAD)模块提取语音片段。

Tokenizer

为了克服传统的语音分词器在理解或生成任务中单独捕获信息的局限性,我们提出了一种类似于ARCON的Step-Audio dual-codebook 语音分词器框架。这种方法使用两种不同的标记器,linguistic 和 semantic,以更好地表示语音特征。linguistic 标记器用于提取结构化的高级表示,包括 phonemic 和 linguistic 特征,而semantic 标记器用于编码语义和粗粒度声学特征。

对于linguistic标记化,我们利用Paraformer编码器的输出,以16.7 Hz的标记率将其量化为离散表示。对于semantic标记化,我们采用CosyVoice的标记器,专门设计用于有效编码生成自然和富有表现力的语音输出所必需的特征,以25 Hz的标记率运行。linguistic标记器使用码本大小为1024,而semantic标记器使用更大的码本大小为4096来捕获更精细的声学细节。

LLM

为了增强Step-Audio有效处理语音信息并实现准确的语音-文本对齐的能力,我们基于Step-1进行了音频预训练,Step-1是一个130B个参数预训练的基于文本的LLM。Step-Audio的预训练和后训练过程的细节在第4节和第5节中进行了全面讨论。

在多轮对话系统中,音频标记和文本标记之间的长度差异需要有效的处理策略。为了解决这个问题,在系统输入之前,利用ASR模型将历史信息转录成文本格式,从而优化计算效率。然而,应该注意的是,模型体系结构保持了在需要时处理和利用音频令牌作为历史上下文的能力。

Speech Decoder

语音解码器由一个3B个参数语言模型、一个flow-matching模型和一个mel-to-wave声码器组成,主要用于接收文本或音频标记,并生成包含历史信息和指令的连续时域风格化波形。为了优化合成语音的可理解性和自然度,使用双码交错方法训练语音解码器,确保在整个生成过程中linguistic和semantic特征的无缝集成。在具有更大参数的语音解码器上,我们观察到增强的生成能力的出现。详情请参阅第5.1节。

Real-time Inference

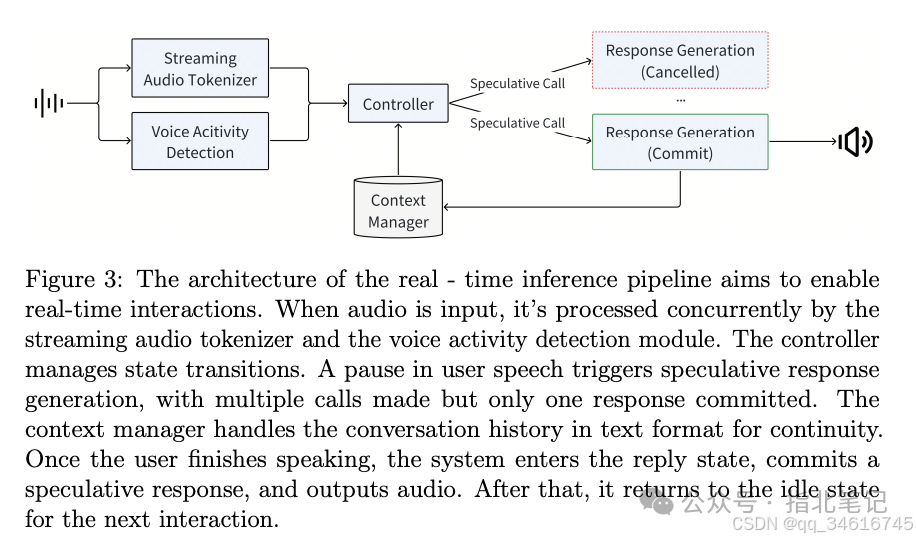

为了实现实时交互,我们设计了一个优化的推理管道,如图3所示。Controller模块的核心是管理状态转换,编排speculative response生成,并确保关键子系统之间的无缝协调。这些子系统包括用于检测用户语音的VAD,用于实时处理音频的Streaming Audio Tokenizer,用于处理和生成响应的Step-Audio语言模型和 Speech Decoder,以及用于保持会话连续性的 Context Manager。

Speculative Response Generation 为了减少交互延迟,系统会先发制人地产生推测响应。这样可以最大限度地减少可感知的延迟并增强响应性,尽管在丢弃推测响应时偶尔需要进行冗余计算。系统以Silence状态启动,等待用户输入。当VAD检测到主动语音时,系统切换到UserSpeaking状态。在此状态下,Streaming Audio Tokenizer 开始将音频转换为标记。如果用户暂时暂停,系统进入UserPaused状态,触发推测响应生成。通过在预期输入完成时抢先生成响应,系统减少了对话恢复时的延迟。如果用户继续说话,则丢弃推测响应。一旦系统自信地确定用户已经完成了说话,它就转换到BotReplying状态,提交最新的推测响应,并提供其音频输出。如果被用户语音打断,系统会优先考虑新的输入,同时保持会话的连续性。完成响应后,系统返回到Silence状态,为下一次交互做好准备。实证分析表明,大约40%的speculative responses是成功的。与非推测方法相比,该机制将每个响应延迟减少了大约500ms。

Audio Tokenizer改造成流式的了;VAD检测语音和打断。预存预取降低交互系统延迟。

Context Management 我们的系统在历史上下文中使用文本转录而不是原始音频标记,因为它提供了更紧凑的表示(平均文本与音频标记的比例为1:14),提高了性能,并在对质量影响最小的情况下实现了更长的对话。ASR异步地将用户语音转录成文本,保持准确和最新的会话历史。

历史用文本,节省context和计算,且性能不变。

Streaming Audio Tokenizer 输入音频流通过两个并行的标记器管道进行处理,每个管道都采用fixed-duration segmentation。产生的令牌以2:3的交错比例无缝地合并到单个序列中。如果没有流音频标记器,推理时间将明显变慢,这取决于音频输入的长度。

两个tokenizer同时跑,利用的固定分段做流式(伪流式)。生成的tokens已2:3的比例交错。

Pretrain

Dataset

我们的多模态预训练数据集集成了三大类数据资源:audio、text和images。

-

• 音频部分包括1.1T tokens of 音频数据(约730万小时)、113B tokens of TTS(文本到语音)合成语音数据(约70万小时)、105B tokens of ASR(自动语音识别)数据(约65万小时)和350B tokens of audio-text 交替数据(约200万小时)。 -

• 文本数据总计800B个令牌,包括网络文档、书籍、代码和专有材料。 -

• 图像部分包括来自网页、书籍和专有资源的800B个image-text 配对/交替数据令牌。

Training Detail

Step-Audio是Step-Omni的一个组成部分,Step-Omni旨在为语音、图像和文本训练统一的预训练模型。该训练基于预训练的文本模型和图像编码器进行持续预训练。整个过程共分为三个阶段。

-

•Stage1: 我们通过添加5120个音频标记来扩展预训练文本模型的词汇表,并集成了一个预训练的图像编码器来形成Step-Omni模型。在训练过程中,为了确保文本模型的能力损失最小,文本模型主干的学习率始终保持在较低的水平(2e-5)。然而,Embedding和语言模型(LM)Head 的学习率被设置为主干的五倍,以促进新添加的令牌的更快收敛。同时,图像编码器在整个训练过程中保持冻结状态。在这个阶段,音频、文本和图像数据以2:1:1的比例使用,音频数据仅由纯音频延续任务组成。

backbone 的学习率是2e-5,lm head 和 embedding的学习率是1e-4,为了学习audio token的映射。数据混合比例为 audio:text:image = 2:1:1,其中audio是纯音频。

-

•Stage2: 在stage1阶段对1.2T标记进行训练后,我们将audio-text交错数据纳入进一步训练,音频延续数据与audio-text交错数据的比例为1:1。在这个阶段,音频、文本和图像数据的比例保持在2:1:1。

保持 audio:text:image = 2:1:1 比例不变,其中audio改为 audio: audio-text = 1:1。增加audio-text数据。这里的audio-text interlevaed data 是什么含义?从后面看不是TTS和ASR数据。看后文,猜测是类似QA对儿的数据,即audio Q, text A;音频文本交叉排列的。这里的audio和text应该是类似对话的关系,或别的,但不是ASR、TTS或翻译的关系。

-

•Stage3: 在第二阶段对 800B tokens 进行训练后,我们将ASR和TTS数据合并进行进一步的训练。音频延续数据、audio-text交错数据、ASR数据和TTS数据的比例设置为1:1:1:1。在此阶段,音频、文本和图像数据的比例调整为4:3:3。此外,嵌入和LM head的学习率与主干同步,利用从2e-5到5e-6的余弦调度。

audio: text: image = 4:3:3,其中音频数据比例为 audio: audio-text: ASR: TTS = 1:1:1:1,增加ASR和TTS数据。

Training Infrastructure

我们在数千个H800 gpu上训练Step-Omni,具有35%的 Model Flops Utilization(MFU)。尽管采用了标准的优化,如定制GPU内核和通信重叠,我们强调了两种创新的方法,进一步提高了我们的训练效率。

Disaggregated Data Processing Step-Omni训练中多模态数据的处理是计算密集型的,通常需要大量的CPU资源来跟上模型训练的速度。传统的实现通常将数据处理任务与训练任务放在一起,导致这些任务之间的严重干扰,最终减慢了训练过程。为了解决这个问题,我们介绍了StarWeaver,一个基于rpc的分布式数据处理库。StarWeaver将cpu密集型的数据预处理任务转移到远程进程,从而减轻了GPU训练端的计算负担,提高了整体训练效率。StarWeaver还有助于增强数据并行维度的负载平衡,因为它是使用全局工作负载信息重新分配数据的理想机制。

Disaggregated Model Placement 对于像StepOmni这样的多模态模型,训练通常不仅涉及LLM,还涉及模态编码器(例如,视觉编码器)。集成这些不同的组件挑战了训练框架的传统假设,即模型是同质的和单一的。这种不匹配通常会导致次优训练效率。为了解决这个问题,我们提出分解模型放置,为每个子模型分配专用资源并采用定制的并行策略。该方法有效地减少了由于模型非均质性引起的管道气泡,从而达到最佳的训练效率。详见(Zhang et al., 2024)。

Exploring Tokenizer for Audio Pretraining

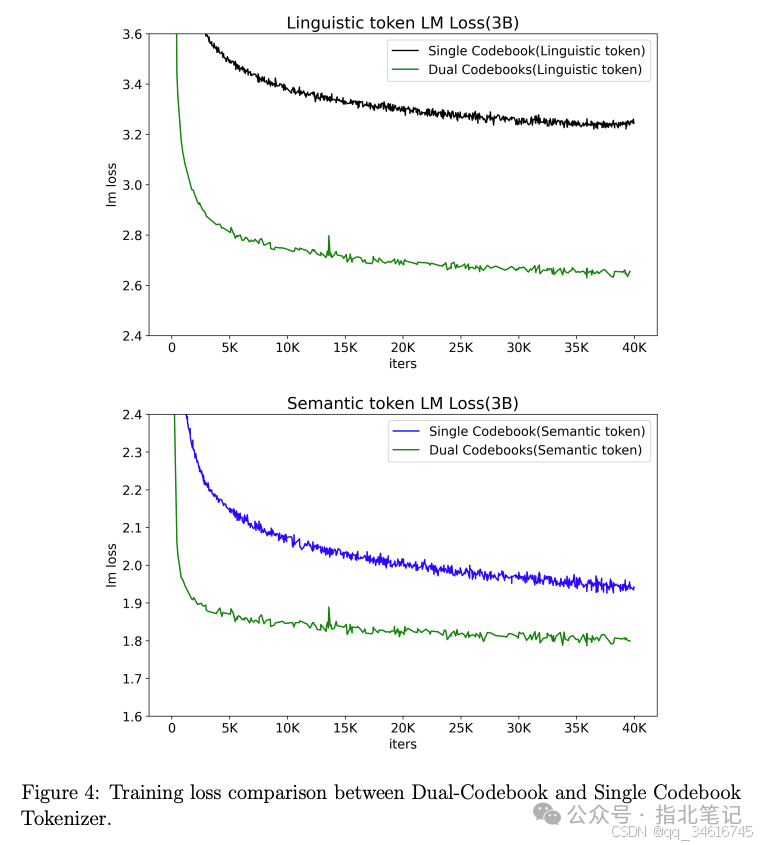

为了实现语音理解和生成的统一,我们首先探索了语音标记器的使用。最初,我们研究了使用单个codebook的训练方法。在我们的实验中,我们发现当只使用semantic标记训练模型时,下一个标记的预测困惑度相对较低,并且生成的内容与前一个上下文之间的语义一致性较好。然而,由于丢弃了太多的semantic符号,导致声学信息的严重损失,通过声码器进行的后续音频恢复在音色和韵律方面存在严重退化,导致听觉质量差。当只使用linguistic标记进行训练时,声码器从模型的延续中恢复的音频听起来不错,但下一个标记的预测困惑度很高,延续与前一个上下文之间的语义一致性较差。当使用semantic标记和linguistic标记交错训练时,semantic标记保证了与前一上下文的延续的语义一致性,linguistic标记保证了重构音频的听觉质量。由于semantic标记和linguistic标记之间的相互引用,我们观察到,当使用双码本训练时,与使用单个码本相比,semantic标记和linguistic标记的下一个标记预测困惑度都降低了,如图4所示。值得注意的是,semantic标记的下一个标记预测困惑度的降低更为显著。此外,ASR消融结果表明,与纯单码本模型相比,双码本模型在ASR测试集上实现了更低的字符错误率(CER)(见6.2.1节)。

此外,linguistic离散令牌和semantic离散令牌以2:3的比例分组交错,使训练损失收敛更快。更重要的是,用 linguistic 标记扩展 CosyVoice semantic标记增强了模型理解和遵循多轮历史指令的能力,也减轻了发音不清和不清楚的发音等问题,显著提高了CosyVoice‘s single code 的性能。

Post-Training

TTS

输入text,输出dual-codebook。

Dataset

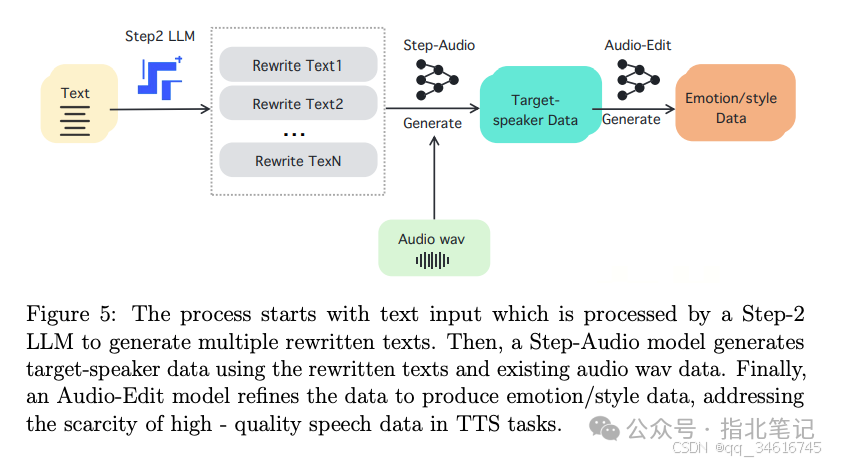

高质量的语音数据对TTS任务至关重要,因为它直接影响到模型的性能和生成语音的表现力。语言特定数据、方言数据、说话风格、情感数据和副语言数据都非常稀缺。构建这样的数据集需要大量的人力和财政资源,而且这个过程通常需要很长的时间。

为了解决这一差距,我们提出了第一个新的synthetic 数据驱动的TTS系统框架,包括三个关键组成部分:

-

• 首先,我们使用Step-2 (StepFun, 2024b) LLM来生成语言多样化和语义丰富的文本内容。 -

• 其次,我们选择了一个pre-trained的Step-Audio模型检查点,该检查点包含audio-token cooldown 机制,可以直接生成特定于说话人、依赖于语言和方言感知的音频数据。

cooldown 指的是什么?

-

• 第三,我们通过微调上述检查点开发了一个Audio-Edit 模型,专门用于生成细微的情感表达和不同的说话风格。该模型架构允许对副语言特征进行精确控制,同时保持说话人的一致性。

Language and Dialect利用StepAudio强大的延续能力,我们生成目标说话人、语言和方言数据。StepAudio已经在大量的说话人和语言数据上进行了训练。基于文本的 LLM Step-2用于翻译和重写聊天文本,以符合目标语言或方言的语法和风格。我们从母语人士那里收集录音和文本作为提示音频和文本,然后使用格式[system prompt; prompt text; target text; prompt code; target code]以及相应的文本,我们使用Step-Audio进行音频延续生成。这种方法只需要少量的高质量种子数据,就可以为目标语言和方言快速创建大量的母语数据。

Emotion and Speaking Styles情绪和说话风格数据一直具有挑战性,因为很难区分和定义情绪类别及其各自的强度,以及准确描述和记录各种风格类型的复杂性。为了解决这个问题,提出了一种基于 Audio-Edit 模型的方法。它巧妙地将复杂的情感和风格描述转换为comparative pair data construction format。Step-2 用于重写具有特定情感和风格的聊天文本。收集来自同一说话者具有相同文本的正常和情感语音样本,并使用Step-Audio 进行克隆和延续生成以创建(text, neutral audio token, emotion and style audio token)数据。仅使用(neutral audio token, emotion and style audio token)对儿,对音频cooldown预训练模型执行SFT以获得Audio-Edit模型。使用该模型,可以输入中性风格的语音生成情感或风格增强音频,迭代生成不同情感或风格强度的数据。

It ingeniously converts complex emotion and style descriptions into a comparative pair dataconstruction format.

Singing and RAP我们通过三个阶段构建了一个歌词(lyrics)和人声(vocal)片段的配对数据集:(1) 收集超过10,000小时的带有LyRiCs-format 时间戳的唱歌/ RAP曲目;(2) 使用Demucs提取干声,并通过语音活动检测(Voice Activity Detection, VAD)去除静音区域;(3) 使用 LyRiCs 时间戳分割音频,并将歌词与音频片段对齐。对于数据清洗,我们执行了三个步骤:(1)RAP分离:我们通过保留较高 speech rate 的RAP片段来分离纯RAP片段,并使用genre分类模型来识别 hip-hop 片段;(2)音频质量滤波:利用noise detection 和 speaker diarization,保留低噪声的单说话人片段;(3)对齐验证:为了解决由于 LyRiCs 时间戳不准确导致的不对齐问题,我们计算了转录语音和基本真实歌词之间的字符错误率(CER),丢弃了不对齐的片段。最终,保留的音频片段的总长度占原始歌曲长度的17.8%。该数据集支持双重训练目标:LLM学习将歌词映射到linguistic和semantic标记,而speech decoder 将这些标记解码成精确曲调中的高保真人声。

Target Speaker通过基础语言和方言数据的模型泛化,为目标说话者支持多种语言或方言是具有挑战性的,因为它通常无法达到母语说话者的水平。为了缓解这个问题,我们使用了从音色和韵律与目标说话者相似的母语人士生成的音频中提取的 dual codes。这些dual codes与目标说话人的提示音频结合生成新的音频,然后从中再次提取dual codes。通过这个简单的过程,目标说话者在新语言和方言中的讲话变得更像母语人士。

we employ dual codes extracted from audio generated by native speakers withtimbre and prosody similar to the target speaker. These dual codes are combinedwith the target speaker’s prompt audio to regenerate new audio, from which dualcodes are then extracted again

数据的质量评估是我们 synthetic 数据框架的关键组成部分。为了确保种子数据和合成数据的可靠性和有效性,我们实施了一个综合评估系统,包括多个客观指标:ASR准确性、语音活动检测(VAD)性能、说话人Diarization精度、情绪识别一致性和深度噪声抑制(DNS)有效性。这种多维质量控制机制保证了生成的合成数据的鲁棒性和实用性。

Training Detail

传统的TTS系统强调对说话者特征、情感表达、语言特征和风格元素的细粒度控制,与之相反,我们的方法采用了基于聊天的范式和LLM的训练方法。这种战略一致性显著提高了系统的灵活性,同时建立了一个可扩展的框架,以支持未来的模型和数据扩展,从而解决了语音合成系统中可扩展性的关键挑战。

TTS的SFT数据按照对话的风格组织,包括(the system prompt, the human input, and the assistant response)。

Supervised Fine-Tuning FormatSFT 格式包括三个基本组成部分:system prompt、human input和 assistant response,以两轮对话配置的形式结构化。在这种格式中,system prompt 用作指定说话人属性和定义支持的instruction tags的基本元素。human input 和 assistant response 组件分别专门用于处理文本内容和dual-codebook表示。第一轮的文本和音频标记可以用来保持 in-domain 说话人的音色和风格的一致性,以及实现 out-domain 的 zero-shot 克隆。

Instruction Tags指令标签分为两类:描述性标签和比较性标签。描述性标签用于控制语言、方言、声音和风格等方面,而比较性标签用于控制情感和速度的等级区分。描述性标签的数据是使用Step-Audio模型克隆生成的,支持语言和风格,包括日语、韩语、广东话、四川话、可爱的声音、RAP和唱歌。比较标签的数据是使用Audio Edit模型生成的,支持快乐、愤怒、悲伤等情绪,以及快速和缓慢等速度变化,每一个都分为五个层次。

comparative tags 分为 5 级。

我们采用第5.1.1节中概述的SFT数据。并利用 3B 参数模型,以的初始学习率训练一个epoch。学习率使用余弦衰减策略进行调整,下界设置为。

AQTA

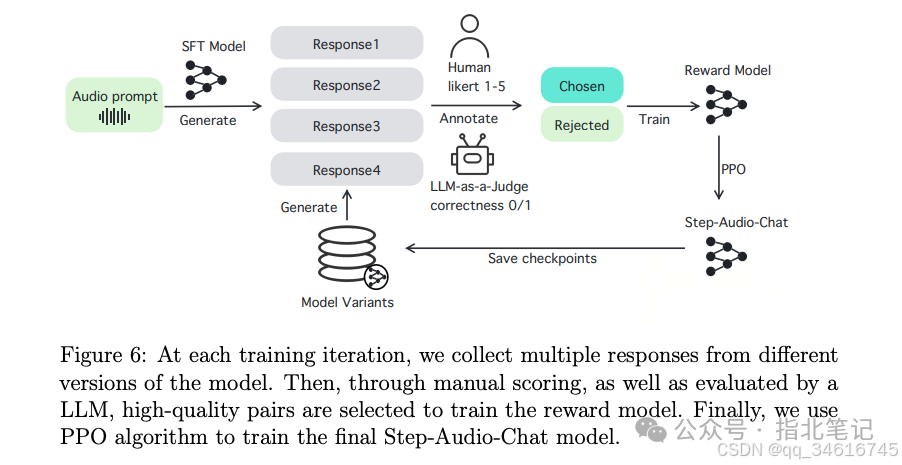

我们将基于人类反馈的强化学习(RLHF)应用于AQTA任务,从而创建了Step-Audio-Chat模型,如图6所示。

SFT dataset

Data Types我们根据输入(Q)和输出(A)的性质将SFT数据分为几种类型:

-

•TQTA: 此类型包括大量基于文本的问答(QA)数据。 -

•AQTA: 这种类型由音频输入和文本输出配对组成。 -

•TAQTA:这种类型旨在增强文本和语音之间的一致性。在这里,文本Q既可以作为输入(不参与损失计算),也可以作为输出(参与损失计算)。 -

•Other Types: 其中包括 audioQ-audioA(AQAA)、visionQ-audioQ-textA(VAQTA)等。包括这些类型是为了给训练数据提供额外的多样性和复杂性,进一步提高模型的鲁棒性。

为了增强语音识别能力,我们在现有数据集的基础上加入了以ASR格式注释的额外训练数据。这些asr格式的资源包含语音信号的详细转录,使模型能够更好地解释phonetic模式和linguistic的细微差别。这些补充asr注释数据的集成增强了模型对声学变化的鲁棒性,包括区域口音、说话速率波动和环境噪声干扰。

Data Processing为了优化SFT数据以进行有效的模型训练,我们执行了以下处理步骤:

-

•Single-Turn Data Modification: 对于单轮交互,我们对输入应用了文本长度过滤。这是因为实际用户的语音输入通常是简洁的。此外,我们修改了输出以采用更具会话性的文本风格,增强了语音模型的类人特性,避免了僵化、冗长或过度结构化的响应。 -

•Multi-Turn Data Processing: 对于多轮交互,我们用相应的文本转录替换了之前回合的语音输入。只有最后一轮的语音输入被保留。此外,在损失计算中只考虑最后一轮的响应,将模型的训练重点放在对最近的输入产生准确和相关的响应上。

通过这种系统的SFT数据构建和处理方法,我们的目标是创建一个多样化和具有代表性的数据集,使我们的语音模型能够在现实场景中实现卓越的性能,为用户输入提供自然、连贯和上下文适当的响应。

Supervised Fine-Tuning Details

我们使用第5.2.1节中描述的SFT数据。模型经过1 epoch的微调,学习率在~之间。

Reward Model dataset

TQTA Preference Data Construction我们收集了由TQTA模型生成的人类偏好数据(例如Step-1和Step-2),并删除了在语音对话中分布较少的类别,例如代码和数学。我们主要保留了日常对话、角色扮演、安全和指令遵循等类别。

AQTA Preference Data Construction对于微调数据集,我们首先收集了来自用户的真实音频提示,并使用SFT模型对四个响应进行了采样。然后,我们让人类注释者根据指令遵循、会话自然度和安全性的标准,以1到5的等级对这四个回答进行评分,从而构建chosen/rejected pairs。除了这些人工生成的标签外,我们还采用LLM-as-a-Judge方法对模型对客观问题的回答进行评分,并根据回答的正确性创建相应的选择/拒绝对。为了减轻5.2.6中描述的与“deaf hacking”相关的模式偏差,我们使用被黑客入侵的PPO模型来生成具有清晰音频提示的输入音频响应。如果响应表现出黑客行为,我们将其构建为拒绝响应。这一过程旨在消除奖励模型训练数据中“deaf hacking”作为选择响应的排他存在所造成的模式偏差。

Reward Model Training Details

我们实现了一种两阶段的奖励模型训练方法:TQTA单模态偏好模型预训练,然后是AQTA跨模态微调。该模型在TQTA和AQTA上分别进行了1个epoch的微调。学习率使用余弦衰减策略进行调整,初始值为,下界设置为。

奖励模型训练从SFT模型初始化,并使用Bradley-Terry损失进行两阶段训练,在人类偏好测试集上获得了70.51%的成对准确率。

PPO dataset

对于PPO训练数据,我们使用了与奖励模型AQTA微调阶段相同的提示种子。

PPO Training Details

在获得奖励模型后,我们采用 PPO 算法训练语音大语言模型。在RLHF训练阶段,critic模型被预热了最初的80个训练步骤。我们采用PPO clip阈值为,初始学习率为,使用余弦策略衰减,最小学习率为。另外,我们将KL惩罚系数设为。

与在TQTA模型的RLHF训练中观察到的 reward hacking 不同,我们发现,仅在人类注释的AQTA偏好数据上训练的奖励模型表现出一种 “deaf hacking” 现象(即,奖励模型对包含“I didn’t hear clearly”等短语的 response 给予高奖励,而不考虑输入音频的清晰度,无意中强化了RLHF训练中的 deaf hacking 模式)。我们将这一问题归因于奖励模型训练数据中的模式偏差,该模型只以“deaf hacking”对儿为特征:模型对选择的回答中不清楚或语义不完整的提示做出“I didn’t hear clearly”的反应,但对拒绝的提示中清晰和语义完整的提示却缺乏这样的反应。为了减轻这种偏差,我们构建了5.2.3节中提到的相应数据。我们还计划在RLHF训练中引入基于规则的奖励,在未来的工作中消除“deaf hacking”。

Evaluation

Benchmark Design

我们创建了一个新的基准,命名为StepEval-Audio-360,遵循一系列规则。在设计原则上,该基准旨在填补多模态语音交互评价的空白,系统识别模型的优缺点,重视用户体验和安全性。在数据收集方面,将真实用户记录与公共语料库结合使用。同时,对音频质量和语义标注进行严格控制,确保符合隐私。

评价维度主要包括语言能力、情商、逻辑推理、创造力、多指令跟随、角色扮演、安全等。人口统计学差异(年龄/性别/方言)、环境条件(噪音水平/麦克风类型)和韵律特征(语速/发音模式)也被考虑在内。指标体系架构结合定量分析,使用脚本对准确率、重复率等指标进行自动验证,并涉及大型语言模型和人工评估。此外,每季度对基准进行更新,以避免落后,并根据用户反馈进行调整。

Results

ASR

我们使用3B模型进行验证实验,比较 Semantic Code 和 Dual-Code 在ASR(自动语音识别)任务中的性能。在保持相同音频训练数据量的情况下,Dual-Code方法的字符错误率(CER)从 25.5 降低到18.4。这表明 Dual-Code 方法显著提高了ASR任务的性能。

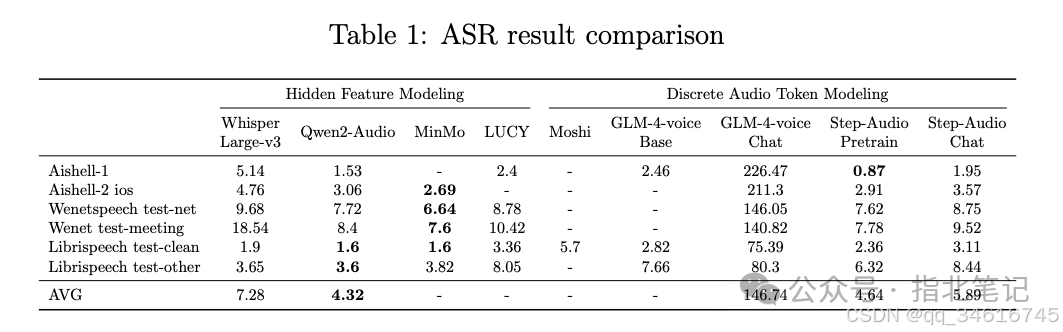

我们在两个阶段测试了模型的性能:首先,预训练模型(Step-Audio Pretrain);二是聊天模型(Step-Audio-Chat),在与人类偏好对齐后,使用系统提示“请记录下你所听到的语音内容。”。评估数据集包括:aishel1、Aishell2 ios、Wenetspeech test-net、Wenetspeech test-meeting、librisspeech test-clean、librisspeech test-other。对于评价指标,我们采用汉字错误率(CER)和英语单词错误率(WER)。我们系统地比较了以下两类主流的大语音模型:

-

• Hidden feature modeling: Whisper Large-v3, Qwen2-Audio , MinMo, LUCY; -

• Discrete audio token modeling: Moshi, GLM-4-voice, Step-Audio.

具体结果如表1所示。在基于音频token的语音模型中,Step-Audio Pretrain的平均CER为4.64,表现最佳。与隐藏特征模型相比,Step-Audio Pretrain优于Whisper Large-v3,并取得了与Qwen2-Audio和MinMo相当的结果,特别是在aishel1, aishel2和librisspeech test-clean测试集上,其中Step-Audio Pretrain(平均CER 2.05)非常接近Qwen2-Audio(平均CER 2.06)。这表明Step-Audio通过 dual-codebook compression 策略,在语音表示离散化过程中有效地保留了语义信息。

此外,我们比较了最终会话模型的ASR功能。在测试 GLM-4-voice Chat 模型时,我们试验了各种提示,并最终选择了“请写下你听到的语音内容:”提示进行评估。然而,该模型仍然难以有效地遵循指示。相比之下,Step-Audio Chat模型的平均CER为5.89,保持了较强的性能,这反映了其强大的指令遵循能力。

TTS

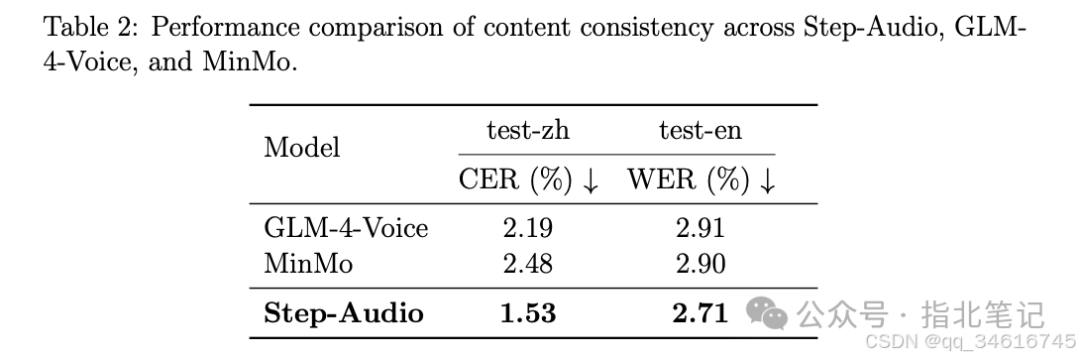

为了评估 Step-Audio 的 TTS 性能,我们使用了SEED TTS测试数据集。该模型被提示重现原始输入文本。虽然这种方法不能保证输入和输出内容的一致性,但我们认为错误的输出也客观地反映了模型遵循指令的能力。因此,我们分别使用Paraformer 和Whisper-Large-V3 计算中文和英文的错误率。结果总结在表2中。Step-Audio在开源语音模型中取得了最好的CER和WER性能。

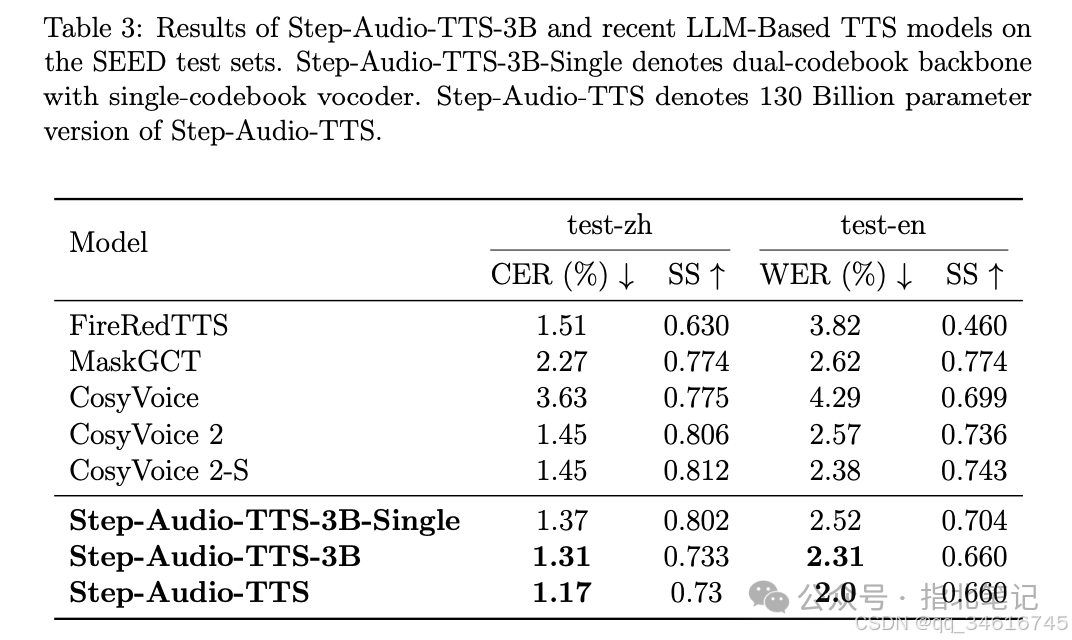

对于TTS任务,我们使用 Paraformer 和 Whisper-Largev3 评估了开源TTS模型在SEED测试集上的性能。使用 ERes2Net 模型评估说话人相似度。结果总结在表3中。我们的具有 dual-codebooks 的Step-Audio-TTS-3B的 3B 参数版本在开放源代码模型中,在CER和WER方面达到了SoTA的结果,同时也显示出极具竞争力的相似度得分。值得注意的是,将 LLM 扩展到130B个参数,在CER和WER方面都有了实质性的改进,这表明进一步扩展合成数据和模型参数的潜在好处。

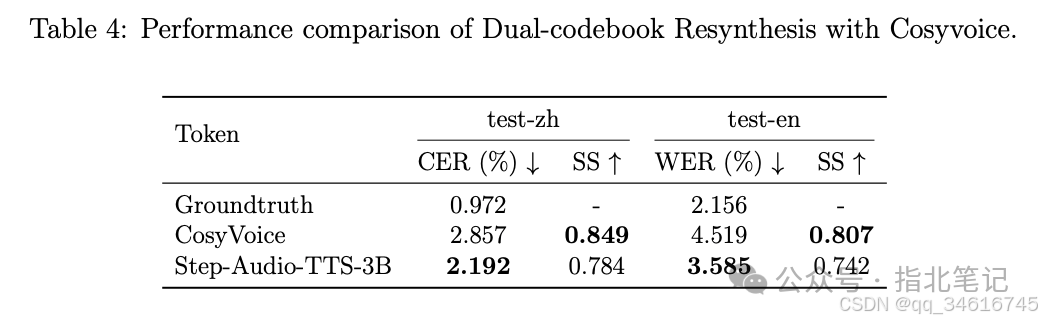

为了评估 dual-codebook 方法的好处,我们比较了各种令牌的重新合成质量,包括:single cosyvoice codebook 和 dual-codebook,在上述SEED测试集中。测试语音首先被量化为离散标记,然后使用token2wav过程重构为波形。我们在语音可理解性和说话人相似性方面评估标记的质量。表4显示了这种比较的结果,它表明 dual-codebook 方法在保持可接受的说话人相似性退化水平的同时实现了较低的CER。

AQTA Chat

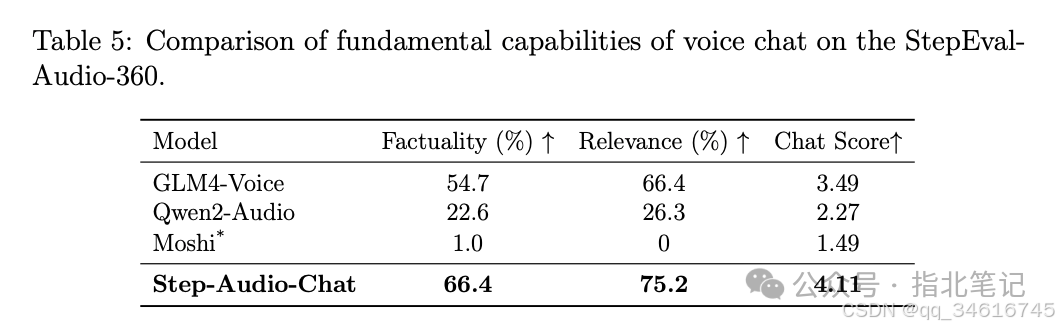

如表5所示,我们使用6.1节中提到的 StepEval-Audio-360 基准测试,比较了Step-Audio和开源模型的实时对话性能。每个指标的分数由 GPT-4o 自动评估。平均分数在表格中显示,最好的结果用黑体显示。由于本基准测试的主要内容为中文,而Moshi几乎不懂中文,所以Moshi的测试结果打了“*”,仅供参考。结果表明,Step-Audio-Chat在实时对话中表现出优异的性能。

-

•Factuality: Step-Audio-Chat 得分最高,达到 66.4%,明显超过其他模型。这表明Step-Audio-Chat提供的回答更准确、更可靠,与事实信息密切相关。 -

•Relevance: Step-Audio-Chat在相关性方面也表现出色,得分为75.2%,这表明它能够为用户查询生成上下文合适且有意义的响应。 -

•Chat Score: 凭借最高的聊天总分(4.11),Step-Audio-Chat提供了卓越的整体语音聊天体验。这个分数从1分(最低)到5分(最高),代表了 GPT-4o 基于对话文本输入和输出的综合评估。

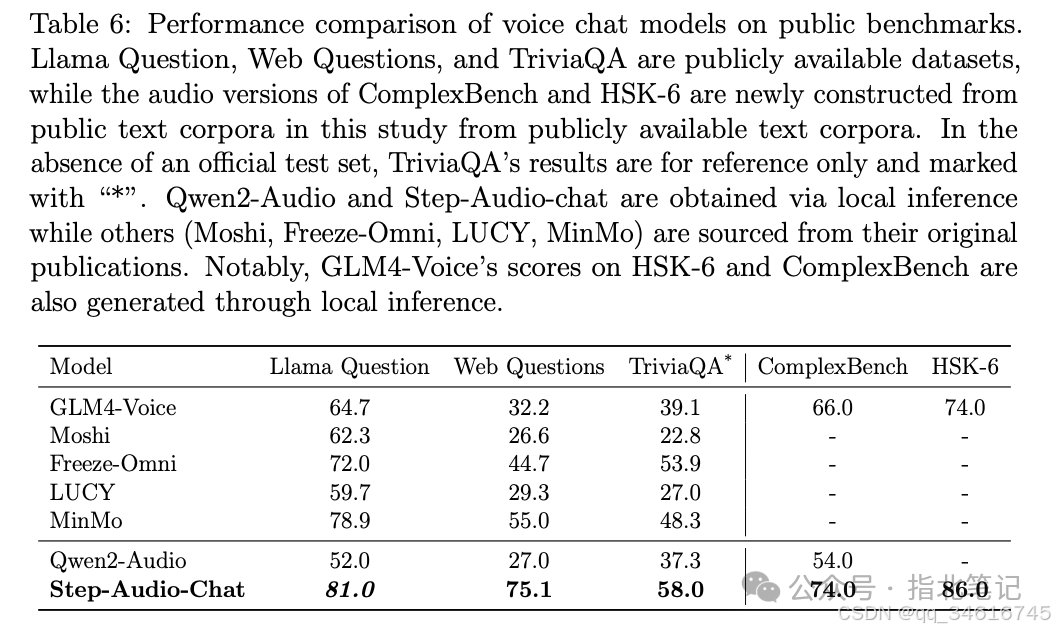

为了进一步了解Step-Audio-Chat的性能,我们对几个公开可用的数据集进行了评估。其中,Web Questions、Llama Questions和TriviaQA是基于知识的问答数据集,ComplexBench和Hanyu Shuiping Kaoshi(HSK-6)的听力部分是综合测试。我们使用了 Web Questions 和Llama Questions 的完整测试集。对于缺乏官方测试集真实答案的 TriviaQA,我们从开发集构建了一个包含1000个样本的测试集。这个子集包括来自Wikipedia和Web验证集的500个样本,并补充了来自Web和Wikipedia开发集的数据。由于此非标准测试集,TriviaQA结果应被视为初步结果,仅供参考。虽然Llama Questions提供口语试题,但我们使用TTS生成Web Questions、TriviaQA、ComplexBench和HSK-6的口语试题,实现音频问答(AQTA)评估。

Moshi、Freeze-Omni、LUCY 和 MinMo 的性能数据均取自各自的出版物。Step-Audio-Chat和Qwen2-audio 的结果是通过本地API推理得到的。对于LUCY,我们报告了其第2阶段(S2)和第3阶段(S3)训练阶段的最佳结果,如原始出版物中所述。GPT-4o 被用来评估模型对原始文本问题的文本回答的准确性。表6给出了平均准确率分数,表明Step-Audio-Chat在所有开源基准测试中达到了最高的准确率。Step-Audio-Chat在Llama问题数据集上的准确性得分是斜体的,表明我们纠正了评估集中的几个错误。除了自动度量之外,我们还进行了人工评估,如图1所示。结果证实了自动化评估,显示Step-Audio在所有评估维度上都具有清晰和一致的优势。

Instruction Following

音频指令跟踪反映了模型响应输入指令生成准确音频和文本内容的能力。因此,我们开发了音频指令遵循的基准,包括语言、角色扮演、唱歌/说唱和语音控制等类别。评估包括指令遵循的准确性和生成语音的质量,两者都使用1-5的平均意见评分(MOS)量表进行评估。如表7所示,Step-Audio-Chat分别在音频指令遵循和音频质量方面显示了竞争结果。

Toolcall

所提出的Step-Audio系统可以在语音交互期间实现实时工具调用。由于实时文本响应与其对应的音频流之间存在巨大的比特率差异,我们的框架在保持无缝语音交互的同时实现了异步工具调用。如图7所示,该体系结构将基于文本的工具处理与音频生成管道解耦,允许并行执行外部服务查询(例如知识检索)和语音合成。当需要调用工具时,这种设计消除了音频渲染的等待时间,显著提高了交互的流畅性。

Conclusion

在本文中,我们提出了Step-Audio,一个用于实时语音交互的创新框架。在预训练阶段,我们的 dual-codebook 语音标记器使用3.3T多模态数据标记桥接文本和声学模态,建立跨模态对齐。在训练后阶段,我们对TTS和ASR任务进行了特定任务的SFT,并结合RLHF对AQTA任务进行了多样化的高质量数据集的SFT,以提高响应质量,实现对情绪调节、方言适应和韵律模式生成的细粒度控制。通过工程创新,包括speculative流与切片延迟补偿和高效的全双工协调,Step-Audio实现流畅的会话动态。来自包括ASR、TTS和AQTA在内的任务的基准评估的性能指标证明了Step-Audio在语音对话中的卓越能力。

Future Work

在这项工作中,我们展示了Step-Audio目前在语音和文本之间跨模态集成方面的能力,作为Step-Audio针对三模态系统的初步实现的一部分。展望未来,有三个关键领域值得进一步探索:首先,扩展框架以实现包含视觉、语音和文本的原生三模态理解;二是通过消除AQAA场景中的中间跨模态转换,提高纯语音对话效率;第三,实现深度思考增强的工具调用,以增强与外部知识库的智能交互能力。

参考文献

-

• https://arxiv.org/pdf/2502.11946v2 -

• https://arxiv.org/pdf/2501.16327 -

• https://huggingface.co/datasets/stepfun-ai/StepEval-Audio-360 -

• https://github.com/BytedanceSpeech/seed-tts-eval